Bij het samenstellen van een machine vision-systeem, dat is een al dan niet vliegende machine met visuele sensoren die data verzamelt, is de keuze van de camera en lens afhankelijk van verschillende factoren zoals de te detecteren objecten, de gewenste output, de gewenste vliegsnelheid, het beschikbare licht, de temperatuur, de beschikbare ruimte, het maximum toegestaan gewicht en natuurlijk ook de prijs van het complete systeem. In dit artikel lees je een korte beschrijving van de functies en opties die beschikbaar zijn met de sensoren die op de markt zijn. Zo kan u de type sensoren selecteren die pasen bij de behoeften van uw toepassing.

Area scan vs. line scan

Als een grondige inspectie nodig is, moeten camera’s met area scan de eerste keuze zijn. Dit type sensor bestaat uit meerdere lijnen pixels en legt tegelijkertijd het hele beeld vast (ook wel 2D-sensoren genoemd). Dit type camera wordt gebruikt in kwaliteitscontrolesystemen, code scanning (bijv. Barcode, QRcode, …) en voor pick-and-place-toepassingen. De lijnscancamera’s gebruiken een enkele lijn pixels (soms twee of drie lijnen) om de beeldgegevens vast te leggen (bekend als 1D-sensoren). Ze worden meestal gebruikt om de afdrukkwaliteit van kranten te controleren maar ook voor kwaliteitscontroles van plastic films, staal, textiel en voedsel.

Monochroom versus kleur

Als de beoogde applicatie die moet worden gebouwd geen kleurinformatie nodig heeft voor de analyse, dan kun je het beste een monochrome camera gebruiken. Deze sensoren zijn gevoeliger dan kleurencamera’s en leveren meer gedetailleerde beelden op. Kleurencamera’s gebruiken de Bayer-matrix om de kleurinformatie vast te leggen (zie onderstaande afbeelding). Waar elke pixel een kleurenfilter heeft (rood, blauw of groen), heeft de helft van de pixels een groene, een kwart een rode en de rest een blauwe filter. Meer pixels hebben een groene filter om de menselijke waarneming na te bootsen, waarvan bekend is dat ze gevoeliger zijn voor het groene licht. Om de kleur van elke pixel te bepalen, wordt de informatie van aangrenzende pixels gebruikt door het debayering-algoritme. De meeste sensoren die tegenwoordig op de markt verkrijgbaar zijn, hebben dit proces van debayering ingebed, waardoor direct van de sensor zelf het kleurenbeeld met drie kanalen (RGB) kan worden verkregen.

CMOS versus CCD

In CMOS-camera’s (Complementary Metal-Oxide Semiconductor) is de elektronica die het licht omzet in digitale signalen geïntegreerd in het oppervlak van de sensor (bijv. Versterkers, ruiscorrectie en digitaliseringscircuits). Dit maakt de overdracht van de digitale gegevens bijzonder snel. CMOS-sensoren zijn minder duur, vertonen geen uitvloeiing of vlek (zie onderstaande afbeelding voor een voorbeeld van de verticale uitsmering) en hebben een hoger dynamisch bereik. In de auto-industrie is dit laatste kenmerk vrij belangrijk omdat het het mogelijk maakt om zowel een verlichte kentekenplaat als de schaduwpersoon in een auto in hetzelfde beeld vast te leggen.

De CCD-sensoren (Charge-Coupled Device) hebben geen conversie-elektronica op het sensoroppervlak. Wanneer licht de fotoreceptor binnenkomt, wordt het opgeslagen als een elektrische lading in de sensor, vervolgens omgezet in spanning, gebufferd en uitgezonden als een analoog signaal wanneer de sluiter wordt gesloten. Ze kunnen meer licht opvangen en hebben dus een lagere ruisfactor, een hoge vulfactor en een hogere kleurechtheid. Deze eigenschappen maken CCD-camera’s een goede keuze voor toepassingen met weinig licht en lage snelheid, zoals astronomie.

Global versus rolling shutter

Als je vervormingen bij hoge snelheden wilt vermijden en je je niet al te veel zorgen maakt over de prijs, vooral als je een dynamisch proces / systeem hebt, dan is een globale sluitersensor de optimale keuze. Met de globale sluiter wordt het hele sensoroppervlak tegelijk aan licht blootgesteld. Het is geweldig voor applicaties met hoge snelheid, zoals verkeer en transport, of logistiek.

Een rollende sluiter leest een beeld lijn per lijn en de lijnen worden vervolgens opnieuw samengesteld tot één enkel beeld. Als het object snel beweegt of de lichtomstandigheden slecht zijn, wordt het beeld vervormd. Er is echter een oplossing om de vervormingseffecten te minimaliseren door de belichtingstijd van de sensor aan te passen en een zaklamp aan het systeem toe te voegen. Houd er rekening mee dat rolluik-sensoren minder duur zijn en alleen beschikbaar zijn met CMOS-camera’s.

Frame rate (Hz) en belichtingstijd (ms)

De framesnelheid is het aantal afbeeldingen dat de sensor per seconde kan vastleggen en verzenden. Het menselijk brein detecteert ongeveer 14 tot 16 beelden per seconde; de framesnelheid van een film is meestal 24 fps (frame per seconde). Voor snel bewegende toepassingen zoals inspecties van producten op lopende banden, moet de camera bijvoorbeeld worden ingesteld op een integratietijd van milliseconden en afhankelijk van de toepassing zelf en de omgeving kan een extra lichtbron nodig zijn om vervagingseffecten in de gegenereerde afbeeldingen te vermijden. Er zijn andere toepassingen die lage framesnelheden vereisen wanneer het te inspecteren product niet of met lage snelheid beweegt.

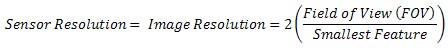

Het vervagingseffect treedt op wanneer het object beweegt terwijl de sensor wordt belicht. Om dit defect te vermijden kan men eerst de maximaal toegestane belichtingstijd berekenen. Dit wordt gedaan met behulp van de onderstaande formule die de snelheid van de object en of de transportband (m/s), de tolereerbare resolutie (pixels), de sensorgrootte (pixels) en het gezichtsveld van het camerasysteem (mm) gebruikt.

max_exposure_time = (max_allowed_image_blur x field_of_view / sensor_size) / conveyor_belt_speed

Afhankelijk van de toepassing zijn verschillende toleranties mogelijk, b.v. een wazig effect van 1 pixel is niet zichtbaar voor het oog, maar heeft nog steeds invloed op de nauwkeurige meetresultaten. Toch is deze waarde acceptabel voor veel standaardtoepassingen. Nuttige belichtingstijden voor CCD-camera’s liggen tussen 50 µs en maximaal 500 ms. Typische waarden in de praktijk voor “normale toepassingen” liggen hoofdzakelijk tussen 0,1 en 20 ms. Met CMOS-sensoren kunnen ook kortere belichtingstijden tot 1 µs worden gerealiseerd. Als de berekening van de belichtingstijd grotere waarden oplevert (bijvoorbeeld 50 ms), is het natuurlijk mogelijk om een kortere belichtingstijd (bijvoorbeeld 5 ms) te gebruiken als er voldoende licht is. Langere belichtingstijden moeten ook worden vermeden omdat trillingen ook in het beeld zichtbaar kunnen worden.

Resolutie

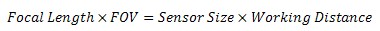

De resolutie van een afbeelding is het aantal pixels in de afbeelding. Dit is in twee dimensies; bijvoorbeeld 640X480. De berekeningen kunnen voor elke dimensie afzonderlijk worden gedaan; maar voor de eenvoud wordt dit vaak teruggebracht tot één dimensie. Om een nauwkeurige meting van de afbeelding te maken, moet u minimaal twee pixels gebruiken per kleinste functie die u wilt detecteren. Om de minimale sensorresolutie te berekenen, vermenigvuldigt u twee (pixels / kleinste element) maal de grootte van het gezichtsveld (in eenheden van de echte wereld) gedeeld door de grootte van het kleinste element:

Meer details hierover vindt u in het voorgaande artikel ‘Camera basics: hoe bereken ik de juiste sensorresolutie en brandpuntsafstand?‘.

Interface

Als de camera op afstand van de pc komt te staan of als je meerdere camera’s in één systeem nodig hebt, zijn GigE-camera’s beter. Het maakt kabellengtes tot 100 m mogelijk en maakt integratie met meerdere camera’s eenvoudig. USB 3.0 biedt echter meer dan drie keer de bandbreedte (350 MB / s versus 100 MB / s voor GigE), is plug-and-play en heeft stroom en gegevens via één kabel, maar werken slechts met kabellengtes tot 8 m. Als een hogere bandbreedte een must is, b.v. tot 850 MB / s, dan is Camera Link de beste keuze. Merk op dat een Camera Link een framegrabber vereist en dat de systeemkosten dus omhoog gaan.

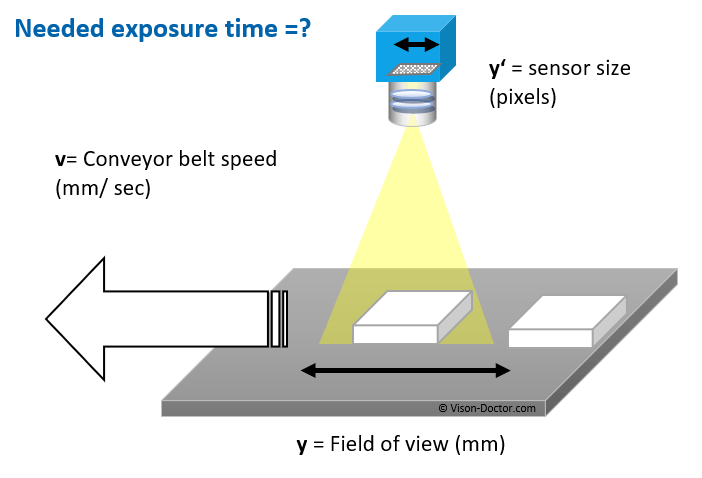

Brandpuntsafstand

Over het algemeen hebben lenzen een vaste brandpuntsafstand. Het is ook gebruikelijk dat de werkafstand flexibel is, dus begin voor eenvoudige berekeningen met een verhouding tussen werkafstand en brandpuntsafstand. Hierdoor kunt u specifieke lensbrandpuntsafstanden gebruiken om de benodigde werkafstand te bepalen. Als de werkafstand beperkt is, krijgen we door deze verhouding om te keren de verhouding tussen brandpuntsafstand en werkafstand. Hierdoor kunt u een reeks werkafstandsopties gebruiken om een brandpuntsafstandbereik te krijgen. Zodra een lens is geselecteerd, kunt u de exacte benodigde werkafstand opnieuw berekenen. Deze berekeningen zijn gebaseerd op de volgende vergelijking:

Lenzen worden vervaardigd met een beperkt aantal standaard brandpuntsafstanden. Veelvoorkomende brandpuntsafstanden van de lens zijn 6 mm, 8 mm, 12,5 mm, 25 mm en 50 mm. Als u eenmaal een lens hebt gekozen waarvan de brandpuntsafstand het dichtst in de buurt komt van de brandpuntsafstand die uw beeldvormingssysteem vereist, moet u de werkafstand aanpassen om het te inspecteren object scherp te krijgen.

Let op: lenzen met een korte brandpuntsafstand (minder dan 12 mm) produceren beelden met een aanzienlijke mate van vervorming. Als uw toepassing gevoelig is voor beeldvervorming, probeer dan de werkafstand te vergroten en gebruik een lens met een grotere brandpuntsafstand. Als je de werkafstand niet kunt veranderen, ben je enigszins beperkt in het kiezen van een lens.

Auteur

Auteur

Merwan Birem

Merwan is Research Engineer bij Flanders Make (Leuven, België) en werkt in het DecisionS core lab. Merwans onderzoek richt zich op de gebieden computervisie (2D en 3D), beeld- en videoverwerking, machine- en deep learning-algoritmen voor detectie, classificatie, kwaliteitscontroleprocessen en robottoepassingen

Contacteer EUKA/Flanders Make voor meer informatie

Updates en nieuwe artikels ontvangen in je mailbox? Schrijf je dan snel in voor onze nieuwsbrief!